Ghost Interview

O “cara” do Machine Learning da Apple

A IA das Big Techs tem a cara desse executivo, que agora lidera a entrada da Apple nos carros autônomos

A mesma tecnologia que nos dá a chance de saber “qual o nome do artista que fez aquele filme dos anos 80 e agora atua em um da Netflix” é a que nos fará entrar num carro que já sabe se dirigir sozinho até o lugar que queremos. Sim, estamos falando de Machine Learning, mas também estamos falando de uma pessoa. Porque a mesma pessoa que criou um dos algoritmos mais populares do Google é a mesma que está liderando a área de veículos autônomos da Apple: John Giannandrea. Ou melhor, o Ghost Interview de hoje.

Giannandrea é o atual vice-presidente sênior de estratégias em inteligência artificial e machine learning da Apple. Ele entrou na Maçã em 2018, literalmente um dia depois de sair do seu posto de líder de Machine Learning, IA e Search Engine no Google. O caminho que o fez entrar no Google também é digno de nota: ele criou uma empresa, chamada Metaweb, que foi comprada pela Big Tech em 2010. Ah, e antes disso, ele foi CTO da Netscape. Ok, com um currículo desse, ele provavelmente é bem qualificado para nos falar, afinal, qual o futuro da IA.

John, sua carreira acabou sendo moldada pela sua passagem como CTO da Netscape. Para começar, nos fale um pouco de como esse trabalho impactou os outros?

Na verdade, quando a minha curiosidade com relação à busca na web acendeu quando estava na Netscape. Por lá, trabalhamos em um projeto de “related browsing”, que era uma ideia que iria permitir que os usuários achassem páginas mais fácil dentro do próprio navegador. Nós achávamos bem estranho que não era possível navegar na Web pelas beiradas, pelos lados; não dava para achar os assuntos correlatos ao que você queria.

(Reportagem publicada no The Verge em 8 de junho de 2012)

O que rolou depois que você saiu da Netscape?

Em 2005, eu me juntei a Danny Hills e Robert Cook para fundar a Metaweb, com uma premissa simples: e se a gente conseguisse catalogar tudo que um computador deveria saber?

Estávamos interessados em construir uma maquete do mundo. Nossos computadores eram extremamente burros com relação às coisas que consideramos corriqueiras. Você aprende sobre as coisas. Você tem algum contexto para a compreensão. Nossos computadores não funcionam assim porque não temos nenhum contexto carregado. Nosso foco foi ensinar aos computadores todas as coisas discretas do mundo. Como? Criando um catálogo que fosse legível por todo tipo de máquina do mundo.

(Entrevista ao The Atlantic publicada em 17 de junho de 2012)

De 2005 até 2010, a Metaweb acabou ganhando um catálogo que tinha de tudo, e era criado de forma colaborativa. Quando vocês foram comprados pelo Google, essa iniciativa se tornou o Knowledge Graph, aquela ferramenta que mostra os conteúdos relacionados a uma pesquisa. Pode explicar um pouco melhor?

Mais fácil explicar com um exemplo. Se você pesquisa sobre Albert Einstein, você pode estar interessado em Albert Einstein por causa de seu trabalho em física ou por causa de seu ativismo pela paz – às vezes temos que colocar Einstein no mesmo balde que Gandhi. Não estamos tentando dizer o que é importante sobre Einstein – estamos tentando dizer o que a humanidade está procurando quando faz pesquisas.

(Reportagem publicada no The Verge em 8 de junho de 2012)

A tecnologia é ótima, mas, assim, você não acha que pode acabar com a nossa memória?

Eu não acho que a memória humana vai atrofiar. Na verdade, a busca “mais inteligente” online nos deixa com um QI uns pontos mais altos. No final, a gente acaba sabendo mais coisas.

(Reportagem publicada no The Verge em 8 de junho de 2012)

O Knowledge Graph usa bastante da inteligência artificial para poder fazer essas conexões. Há alguns anos, você comentou que a inteligência artificial seria “tão esperta quanto uma criança de 4 anos de idade”. De uns anos para cá, começaram a surgir algumas teorias e até medos de que, na verdade, a IA poderia nos substituir. Qual a sua opinião sobre isso?

Ok, acho que, hoje em dia, não tem como dizer que os sistemas de IA vão “parar” nos 4 anos, a AI tem potencial de ser menos genérica.

[sugestão: Acho que, hoje em dia, não tem como dizer que os sistemas de IA estão no nível de uma criança de 4 anos. Eles não conseguem ser tão generalistas.]

Mas acredito que há um hype gigantesco em volta da IA no momento. Há muitas pessoas que estão irracionalmente preocupadas com o surgimento da IA em geral. O aprendizado de máquina e a inteligência artificial são extremamente importantes e irão revolucionar nosso setor. ”

Definitivamente, não estou preocupado com o apocalipse da IA. Eu apenas me oponho ao hype e burburinhos que algumas pessoas estão fazendo.

(Apresentação no TechCrunch San Francisco 2017, publicada no TechCrunch em 19 de setembro de 2017)

Tem um ponto que, quando entrou na Apple, você fez questão de focar na nomenclatura de machine learning no lugar de inteligência artificial. Por que?

Quase tento fugir desse termo inteligência artificial – é uma espécie de big data. É um termo tão amplo, realmente não está bem definido. Tenho tentado usar o termo “machine learning”.

(Apresentação no TechCrunch San Francisco 2017, publicada no TechCrunch em 19 de setembro de 2017)

Mas, pergunta que serve para todos aqui: o que é Machine Learning?

Machine Learning é treinar computadores a partir de exemplos que já existem. E essa tecnologia em si é muito poderosa porque consegue fazer com que as máquinas aprendam atividades inéditas rapidamente.

(Apresentação no evento DataInnovation, conferência de AI da União Europeia em 1 de dezembro de 2020)

Quais atividades, por exemplo?

Todas essas coisas se beneficiam dos principais recursos de aprendizado de máquina que são integrados à plataforma central dos smartphones da Apple, por exemplo. O difícil é encontrar algo onde não estamos usando aprendizado de máquina.

O aprendizado de máquina é muito usado em realidade aumentada. O problema difícil aí é o que é chamado de SLAM: localização e mapeamento simultâneos. Então, tentar entender: se você tem um iPad com um scanner LiDAR e está se movendo, o que ele vê? E construir um modelo 3D do que está realmente vendo.

(Entrevista ao Ars Technica publicada em 6 de agosto de 2020)

O que nos leva a querer entender: como foi a sua entrada no machine learning especificamente da Apple?

Quando entrei na Apple, já era usuário de iPad e adorava o Pencil. Então, eu fui atrás das equipes de software e dizia: “OK, onde está a equipe de machine learning que está trabalhando com escrita à mão?” E não conseguia encontrar. Acontece que a equipe que eu procurava não existia – uma surpresa, já que o aprendizado de máquina é uma das melhores ferramentas disponíveis para o recurso hoje.

Eu sabia que havia tanto aprendizado de máquina que a Apple deveria fazer que era surpreendente que nem tudo estivesse realmente sendo feito. E isso mudou drasticamente nos últimos dois ou três anos. Sinceramente, acho que não há um canto das experiências do iOS ou da Apple que não seja transformado pelo aprendizado de máquina nos próximos anos.

Acho que a Apple sempre representou esse cruzamento de criatividade e tecnologia. E eu acho que quando você está pensando em construir experiências inteligentes, ter integração vertical, desde os aplicativos, aos frameworks, ao silício, é realmente essencial… Eu acho que é uma jornada, e acho que este é o futuro dos dispositivos de computação que temos, é que eles sejam inteligentes, e isso, esse tipo de inteligência desaparece.

Fizemos o Pencil, fizemos o iPad, fizemos o software para ambos. São apenas oportunidades únicas de fazer um trabalho muito, muito bom. Em que estamos fazendo um trabalho muito, muito bom? Permitir que alguém faça anotações e seja produtivo com seus pensamentos criativos em papel digital. O que me interessa é ver essas experiências serem usadas em grande escala no mundo.

(Entrevista ao Ars Technica publicada em 6 de agosto de 2020)

Como a Apple se posiciona em comparação ao Google quando o assunto é machine learning? Já que trabalhou nas duas, pode nos dar essa visão.

O Google é uma empresa incrível, e há alguns tecnólogos realmente excelentes trabalhando lá. Mas, fundamentalmente, seu modelo de negócios é diferente e eles não são conhecidos por enviar experiências de consumo que são usadas por centenas de milhões de pessoas. É difícil encontrar uma parte da experiência em que você não esteja fazendo algum [trabalho] de previsão. Por exemplo, previsões de aplicativos, previsões de teclado ou câmeras de smartphones modernos fazem um monte de aprendizado de máquina nos bastidores para descobrir o que chamam de “destaque”, que é como, qual é a parte mais importante da imagem? Ou, se você imaginar o desfoque do fundo, estará usando o modo retrato.

(Entrevista ao Ars Technica publicada em 6 de agosto de 2020)

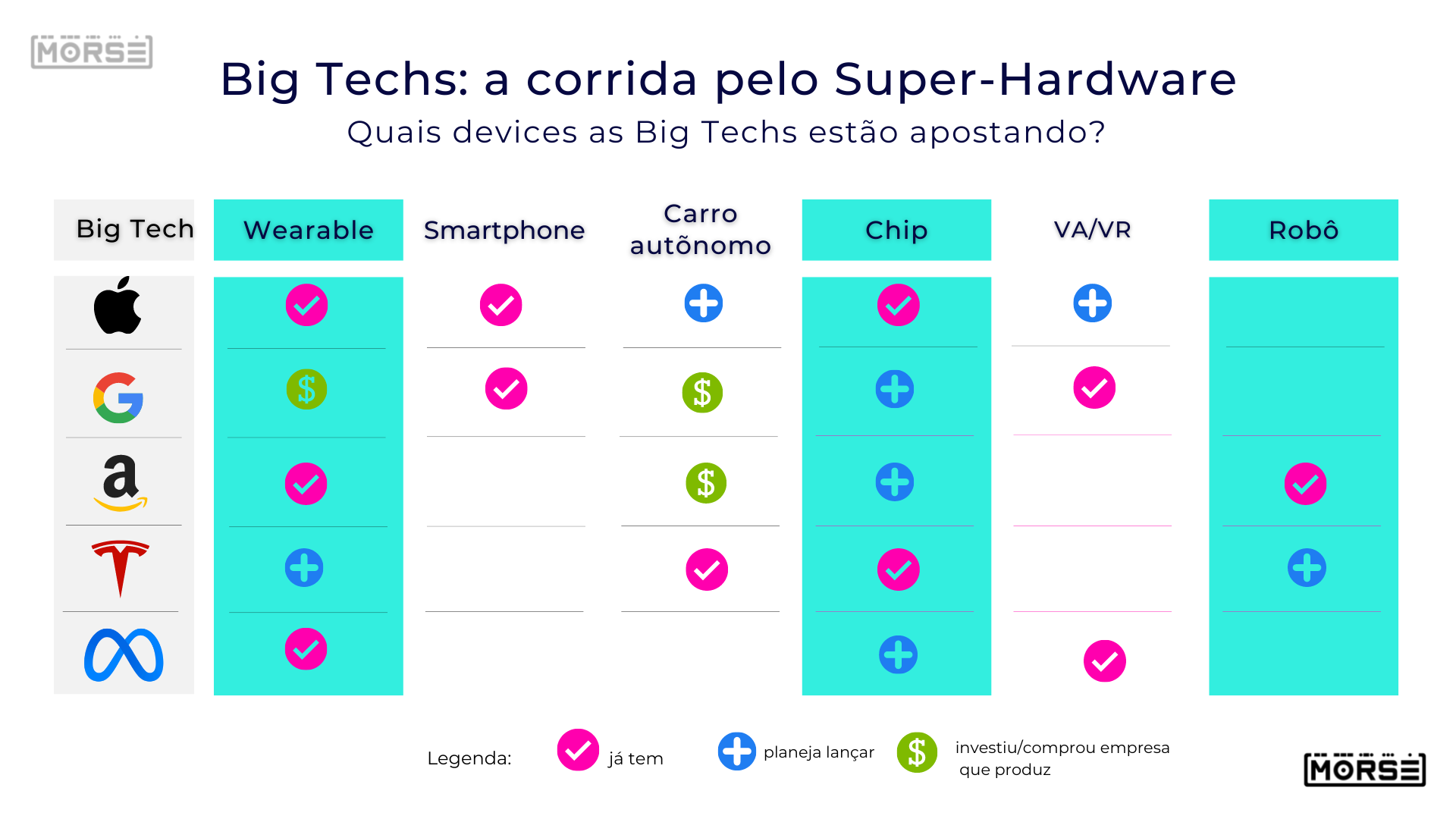

Agora você tocou num assunto que estamos falando bastante: o hardware como a nova fronteira para as prestadoras de serviços digitais. Como você vê o futuro do machine learning?

Tudo que depende de deep learning [a forma mais complexa de machine learning] você precisa ser capaz de fazer diretamente no dispositivo porque deseja fazê-lo em tempo real. Não faria sentido se você estivesse balançando seu iPad e talvez tivesse que fazer isso no data center. Então, em geral, eu diria que a forma como penso sobre isso é que o aprendizado profundo, em particular, está nos dando a capacidade de ir dos dados brutos à semântica sobre esses dados.

Sim, eu entendo que essa percepção de modelos maiores em data centers de alguma forma são mais precisos, mas na verdade está errada. Na verdade, é tecnicamente errado. É melhor executar o modelo próximo aos dados, em vez de mover os dados. E sejam dados de localização – como o que você está fazendo – [ou] dados de exercícios – o que o acelerômetro está fazendo no seu telefone – é apenas melhor estar perto da fonte dos dados e, portanto, também preserva a privacidade.

Você está tirando uma fotografia e, nos momentos antes de tirar uma fotografia com a câmera, a câmera vê tudo em tempo real. Isso pode ajudá-lo a tomar uma decisão sobre quando tirar uma fotografia. Se você quisesse tomar essa decisão no servidor, teria que enviar cada quadro ao servidor para tomar uma decisão sobre como tirar uma fotografia. Isso não faz sentido, certo? Portanto, existem muitas experiências que você gostaria de construir e que são mais bem executadas no edge [ou seja, diretamente no dispositivo].

(Entrevista ao Ars Technica publicada em 6 de agosto de 2020)

-

Ghost Interview5 anos ago

Ghost Interview5 anos agoA inovação segundo Mandic

-

Sem Categoria4 anos ago

Sem Categoria4 anos agoTesla poderia lançar smartphone

-

Morse3 anos ago

Morse3 anos agoInscreva-se na Newsletter!

-

Ghost Interview4 anos ago

Ghost Interview4 anos agoPavel Durov, o polêmico criador do Telegram

-

Morse News4 anos ago

Morse News4 anos agoMorse Audio News

-

Ghost Interview4 anos ago

Ghost Interview4 anos agoCopy.ai: o robô copywriter

-

6 anos ago

6 anos agoSó para Adultos!

-

Ghost Interview5 anos ago

Ghost Interview5 anos agoRoblox: o criador fala tudo!